Déployer des charges de travail avec des travaux Lakeflow d’Azure Databricks

Les travaux Lakeflow Azure Databricks fournissent une plateforme robuste pour déployer efficacement des charges de travail. Avec des fonctionnalités telles que les travaux Azure Databricks et les tables Delta Live Tables, les utilisateurs peuvent orchestrer des pipelines complexes de traitement des données, de Machine Learning et d’analyse.

Ce labo prend environ 40 minutes.

Remarque : l’interface utilisateur d’Azure Databricks est soumise à une amélioration continue. Elle a donc peut-être changé depuis l’écriture des instructions de cet exercice.

Provisionner un espace de travail Azure Databricks

Conseil : Si vous disposez déjà d’un espace de travail Azure Databricks, vous pouvez ignorer cette procédure et utiliser votre espace de travail existant.

Cet exercice inclut un script permettant d’approvisionner un nouvel espace de travail Azure Databricks. Le script tente de créer une ressource d’espace de travail Azure Databricks de niveau Premium dans une région dans laquelle votre abonnement Azure dispose d’un quota suffisant pour les cœurs de calcul requis dans cet exercice ; et suppose que votre compte d’utilisateur dispose des autorisations suffisantes dans l’abonnement pour créer une ressource d’espace de travail Azure Databricks. Si le script échoue en raison d’un quota insuffisant ou d’autorisations insuffisantes, vous pouvez essayer de créer un espace de travail Azure Databricks de manière interactive dans le portail Azure.

- Dans un navigateur web, connectez-vous au portail Azure à l’adresse

https://portal.azure.com. -

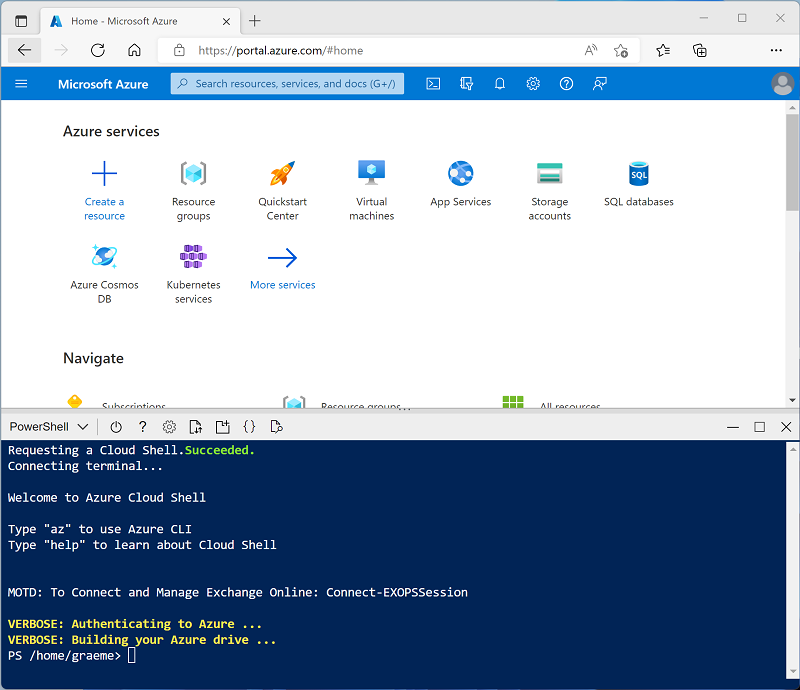

Cliquez sur le bouton [>_] à droite de la barre de recherche, en haut de la page, pour créer un environnement Cloud Shell dans le portail Azure, puis sélectionnez un environnement PowerShell. Cloud Shell fournit une interface de ligne de commande dans un volet situé en bas du portail Azure, comme illustré ici :

Remarque : si vous avez déjà créé un Cloud Shell qui utilise un environnement Bash, basculez-le vers PowerShell.

-

Notez que vous pouvez redimensionner Cloud Shell en faisant glisser la barre de séparation en haut du volet. Vous pouvez aussi utiliser les icônes —, ⤢ et X situées en haut à droite du volet pour réduire, agrandir et fermer ce dernier. Pour plus d’informations sur l’utilisation d’Azure Cloud Shell, consultez la documentation Azure Cloud Shell.

-

Dans le volet PowerShell, entrez les commandes suivantes pour cloner ce référentiel :

rm -r mslearn-databricks -f git clone https://github.com/MicrosoftLearning/mslearn-databricks -

Une fois le référentiel cloné, entrez la commande suivante pour exécuter le script setup.ps1, qui approvisionne un espace de travail Azure Databricks dans une région disponible :

./mslearn-databricks/setup.ps1 -

Si vous y êtes invité, choisissez l’abonnement à utiliser (uniquement si vous avez accès à plusieurs abonnements Azure).

- Attendez que le script se termine. Cela prend généralement environ 5 minutes, mais dans certains cas, cela peut prendre plus de temps. En attendant, consultez l’article Travaux Lakeflow dans la documentation Azure Databricks.

Créer un cluster

Azure Databricks est une plateforme de traitement distribuée qui utilise des clusters Apache Spark pour traiter des données en parallèle sur plusieurs nœuds. Chaque cluster se compose d’un nœud de pilote pour coordonner le travail et les nœuds Worker pour effectuer des tâches de traitement. Dans cet exercice, vous allez créer un cluster à nœud unique pour réduire les ressources de calcul utilisées dans l’environnement du labo (dans lequel les ressources peuvent être limitées). Dans un environnement de production, vous créez généralement un cluster avec plusieurs nœuds Worker.

Conseil : Si vous disposez déjà d’un cluster avec une version 13.3 LTS ou ultérieure du runtime dans votre espace de travail Azure Databricks, vous pouvez l’utiliser pour effectuer cet exercice et ignorer cette procédure.

-

Dans le Portail Microsoft Azure, accédez au groupe de ressources msl-xxxxxxx créé par le script (ou le groupe de ressources contenant votre espace de travail Azure Databricks existant)

-

Sélectionnez votre ressource de service Azure Databricks (nommée databricks-xxxxxxx si vous avez utilisé le script d’installation pour la créer).

-

Dans la page Vue d’ensemble de votre espace de travail, utilisez le bouton Lancer l’espace de travail pour ouvrir votre espace de travail Azure Databricks dans un nouvel onglet de navigateur et connectez-vous si vous y êtes invité.

Conseil : lorsque vous utilisez le portail de l’espace de travail Databricks, plusieurs conseils et notifications peuvent s’afficher. Ignorez-les et suivez les instructions fournies pour effectuer les tâches de cet exercice.

-

Dans la barre latérale située à gauche, sélectionnez la tâche (+) Nouveau, puis sélectionnez Cluster. Vous devrez peut-être consulter le sous-menu Plus.

- Dans la page Nouveau cluster, créez un cluster avec les paramètres suivants :

- Nom du cluster : cluster de nom d’utilisateur (nom de cluster par défaut)

- Stratégie : Non restreint

- Mode cluster : nœud unique

- Mode d’accès : un seul utilisateur (avec votre compte d’utilisateur sélectionné)

- Version du runtime Databricks : 13.3 LTS (Spark 3.4.1, Scala 2.12) ou version ultérieure

- Utiliser l’accélération photon : sélectionné

- Type de nœud : Standard_D4ds_v5

- Arrêter après 20 minutes d’inactivité

-

Attendez que le cluster soit créé. Cette opération peut prendre une à deux minutes.

Remarque : si votre cluster ne démarre pas, le quota de votre abonnement est peut-être insuffisant dans la région où votre espace de travail Azure Databricks est approvisionné. Pour plus d’informations, consultez l’article La limite de cœurs du processeur empêche la création du cluster. Si cela se produit, vous pouvez essayer de supprimer votre espace de travail et d’en créer un dans une autre région. Vous pouvez spécifier une région comme paramètre pour le script d’installation comme suit :

./mslearn-databricks/setup.ps1 eastus

Créer un notebook et ingérer des données

-

Dans la barre latérale, cliquez sur le lien (+) Nouveau pour créer un notebook.

-

Dans la liste déroulante Connexion, sélectionnez votre cluster s’il n’est pas déjà sélectionné. Si le cluster n’est pas en cours d’exécution, le démarrage peut prendre une minute.

-

Dans la première cellule du notebook, entrez le code suivant, qui utilise des commandes du shell pour télécharger des fichiers de données depuis GitHub dans le système de fichiers utilisé par votre cluster.

%sh rm -r /dbfs/workflow_lab mkdir /dbfs/workflow_lab wget -O /dbfs/workflow_lab/2019.csv https://github.com/MicrosoftLearning/mslearn-databricks/raw/main/data/2019_edited.csv wget -O /dbfs/workflow_lab/2020.csv https://github.com/MicrosoftLearning/mslearn-databricks/raw/main/data/2020_edited.csv wget -O /dbfs/workflow_lab/2021.csv https://github.com/MicrosoftLearning/mslearn-databricks/raw/main/data/2021_edited.csv -

Utilisez l’option de menu ▸ Exécuter la cellule à gauche de la cellule pour l’exécuter. Attendez ensuite que le travail Spark s’exécute par le code.

Créer une tâche de travail

Vous implémentez votre workflow de traitement et d’analyse des données à l’aide de tâches. Un travail est composé d’une ou plusieurs tâches. Vous pouvez créer des tâches de travail qui exécutent des notebooks, JARS, des pipelines Delta Live Tables, des envois Spark ou des applications Python, Scala et Java. Dans cet exercice, vous allez créer une tâche en tant que notebook qui extrait, transforme et charge des données dans des graphiques de visualisation.

-

Dans la barre latérale, cliquez sur le lien (+) Nouveau pour créer un notebook.

-

Remplacez le nom de notebook par défaut (Notebook sans titre [date]) par

ETL task, puis dans la liste déroulante Connexion, sélectionnez votre cluster s’il n’est pas déjà sélectionné. Si le cluster n’est pas en cours d’exécution, le démarrage peut prendre une minute.Assurez-vous que le langage par défaut du notebook est défini sur Python.

-

Dans la première cellule du notebook, entrez et exécutez le code suivant, qui définit un schéma pour les données et charge les jeux de données dans un dataframe :

from pyspark.sql.types import * from pyspark.sql.functions import * orderSchema = StructType([ StructField("SalesOrderNumber", StringType()), StructField("SalesOrderLineNumber", IntegerType()), StructField("OrderDate", DateType()), StructField("CustomerName", StringType()), StructField("Email", StringType()), StructField("Item", StringType()), StructField("Quantity", IntegerType()), StructField("UnitPrice", FloatType()), StructField("Tax", FloatType()) ]) df = spark.read.load('/workflow_lab/*.csv', format='csv', schema=orderSchema) display(df.limit(100)) -

Sous la cellule de code existante, utilisez l’icône + Code pour ajouter une nouvelle cellule de code. Ensuite, dans la nouvelle cellule, entrez et exécutez le code suivant pour supprimer les lignes dupliquées et remplacer les entrées

nullpar les valeurs correctes :from pyspark.sql.functions import col df = df.dropDuplicates() df = df.withColumn('Tax', col('UnitPrice') * 0.08) df = df.withColumn('Tax', col('Tax').cast("float"))Remarque : après la mise à jour des valeurs de la colonne Taxe, son type de données est à nouveau défini sur

float. Cela est dû au fait que le type de données a été changé endoubleaprès l’exécution du calcul. Étant donné quedoubleutilise plus de mémoire quefloat, il est préférable de reconvertir le type de la colonne enfloatpour de meilleures performances. -

Dans une nouvelle cellule de code, exécutez le code suivant pour agréger et regrouper les données relatives aux commandes :

yearlySales = df.select(year("OrderDate").alias("Year")).groupBy("Year").count().orderBy("Year") display(yearlySales)

Générer le workflow

Azure Databricks gère l’orchestration des tâches, la gestion des clusters, la surveillance et les rapports d’erreurs pour tous vos travaux. Vous pouvez exécuter vos travaux immédiatement et régulièrement par le biais d’un système de planification facile à utiliser, chaque fois que de nouveaux fichiers arrivent dans un emplacement externe, ou en continu pour vous assurer qu’une instance du travail est toujours en cours d’exécution.

-

Dans votre espace de travail, cliquez sur

Travaux et Pipelines dans la barre latérale.

-

Dans le volet Travaux et Pipelines, sélectionnez Créer, puis Travail.

-

Remplacez le nom du travail par défaut (Nouveau travail [date]) par

ETL job. - Configurez le travail en utilisant les paramètres suivants :

- Nom de la tâche :

Run ETL task notebook - Type : notebook

- Source : espace de travail

- Chemin d’accès : sélectionnez votre notebook Tâche ETL

- Cluster : Sélectionner votre cluster

- Nom de la tâche :

-

Sélectionnez Créer une tâche.

-

Sélectionnez Exécuter maintenant.

-

Une fois que le travail a commencé, vous pouvez surveiller son exécution en sélectionnant Exécutions de travaux dans la barre latérale gauche.

- Une fois l’exécution réussie, vous pouvez sélectionner le travail et vérifier sa sortie.

Vous pouvez aussi exécuter des travaux sur la base d’un déclencheur, par exemple, exécuter un workflow selon une planification. Pour planifier l’exécution périodique d’un travail, vous pouvez ouvrir la tâche du travail et ajouter un déclencheur.

Nettoyage

Dans le portail Azure Databricks, sur la page Calcul, sélectionnez votre cluster et sélectionnez ■ Arrêter pour l’arrêter.

Si vous avez terminé d’explorer Azure Databricks, vous pouvez supprimer les ressources que vous avez créées pour éviter les coûts Azure inutiles et libérer de la capacité dans votre abonnement.