Explorer Azure Databricks

Azure Databricks est une version basée sur Microsoft Azure de la plateforme Databricks open source populaire.

Un espace de travail Azure Databricks fournit un point central pour gérer les clusters Databricks, les données et les ressources sur Azure.

Dans cet exercice, vous allez provisionner un espace de travail Azure Databricks et explorer certaines de ses fonctionnalités principales.

Cet exercice devrait prendre environ 20 minutes.

Remarque : l’interface utilisateur d’Azure Databricks est soumise à une amélioration continue. Elle a donc peut-être changé depuis l’écriture des instructions de cet exercice.

Provisionner un espace de travail Azure Databricks

Conseil : Si vous disposez déjà d’un espace de travail Azure Databricks, vous pouvez ignorer cette procédure et utiliser votre espace de travail existant.

- Connectez-vous au portail Azure à l’adresse

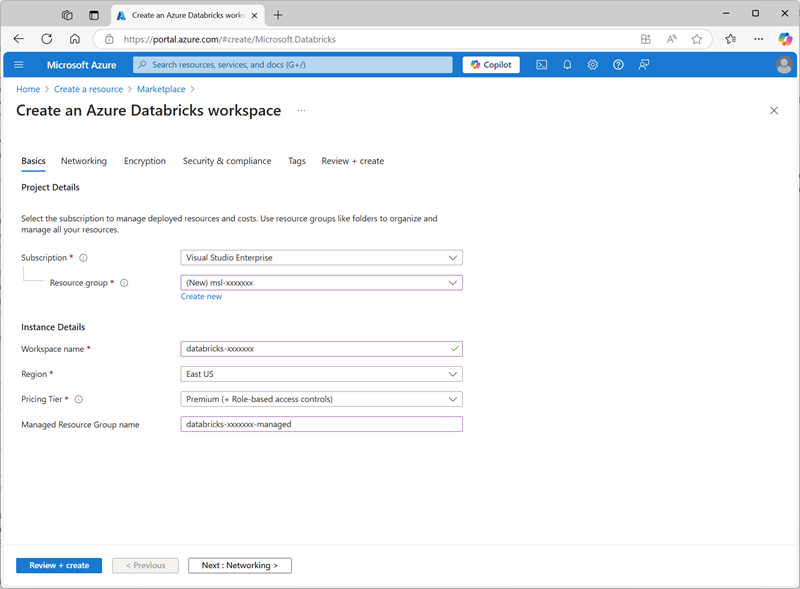

https://portal.azure.com. - Créez une ressource Azure Databricks avec les paramètres suivants :

- Abonnement : Sélectionnez votre abonnement Azure.

- Groupe de ressources : créez un groupe de ressources nommé

msl-xxxxxxx(où « xxxxxxx » est une valeur unique). - Nom de l’espace de travail :

databricks-xxxxxxx(où « xxxxxxx » est la valeur utilisée dans le nom du groupe de ressources) - Région : sélectionnez une région disponible.

- Niveau tarifaire : Premium ou Évaluation

- Nom du groupe de ressources managées :

databricks-xxxxxxx-managed(où « xxxxxxx » est la valeur utilisée dans le nom du groupe de ressources)

- Sélectionnez Examiner et créer, puis attendez la fin du déploiement. Accédez ensuite à la ressource et lancez l’espace de travail.

Créer un cluster

Azure Databricks est une plateforme de traitement distribuée qui utilise des clusters Apache Spark pour traiter des données en parallèle sur plusieurs nœuds. Chaque cluster se compose d’un nœud de pilote pour coordonner le travail et les nœuds Worker pour effectuer des tâches de traitement. Dans cet exercice, vous allez créer un cluster à nœud unique pour réduire les ressources de calcul utilisées dans l’environnement du labo (dans lequel les ressources peuvent être limitées). Dans un environnement de production, vous créez généralement un cluster avec plusieurs nœuds Worker.

Conseil : Si vous disposez déjà d’un cluster avec une version 13.3 LTS ou ultérieure du runtime dans votre espace de travail Azure Databricks, vous pouvez l’utiliser pour effectuer cet exercice et ignorer cette procédure.

- Dans le portail Azure, accédez au groupe de ressources msl-xxxxxxx (ou le groupe de ressources contenant votre espace de travail Azure Databricks existant), puis sélectionnez votre ressource Azure Databricks Service.

-

Dans la page Vue d’ensemble de votre espace de travail, utilisez le bouton Lancer l’espace de travail pour ouvrir votre espace de travail Azure Databricks dans un nouvel onglet de navigateur et connectez-vous si vous y êtes invité.

Conseil : lorsque vous utilisez le portail de l’espace de travail Databricks, plusieurs conseils et notifications peuvent s’afficher. Ignorez-les et suivez les instructions fournies pour effectuer les tâches de cet exercice.

- Dans la barre latérale située à gauche, sélectionnez la tâche (+) Nouveau, puis sélectionnez Cluster. Vous devrez peut-être consulter le sous-menu Plus.

- Dans la page Nouveau cluster, créez un cluster avec les paramètres suivants :

- Nom du cluster : cluster de nom d’utilisateur (nom de cluster par défaut)

- Stratégie : Non restreint

- Mode cluster : nœud unique

- Mode d’accès : un seul utilisateur (avec votre compte d’utilisateur sélectionné)

- Version du runtime Databricks : 13.3 LTS (Spark 3.4.1, Scala 2.12) ou version ultérieure

- Utiliser l’accélération photon : sélectionné

- Type de nœud : Standard_D4ds_v5

- Arrêter après 20 minutes d’inactivité

- Attendez que le cluster soit créé. Cette opération peut prendre une à deux minutes.

Remarque : si votre cluster ne démarre pas, le quota de votre abonnement est peut-être insuffisant dans la région où votre espace de travail Azure Databricks est approvisionné. Pour plus d’informations, consultez l’article La limite de cœurs du processeur empêche la création du cluster. Si cela se produit, vous pouvez essayer de supprimer votre espace de travail et d’en créer un dans une autre région.

Utiliser Spark pour analyser des données

Comme dans de nombreux environnements Spark, Databricks prend en charge l’utilisation de notebooks pour combiner des notes et des cellules de code interactives que vous pouvez utiliser pour explorer les données.

- Téléchargez le fichier products.csv à partir de

https://raw.githubusercontent.com/MicrosoftLearning/mslearn-databricks/main/data/products.csvvers votre ordinateur local, en l’enregistrant en tant que products.csv. - Dans la barre latérale, dans le menu du lien (+) Nouveau, sélectionnez Ajouter ou charger des données.

- Sélectionnez Créer ou modifier une table et chargez le fichier products.csv que vous avez téléchargé sur votre ordinateur.

- Dans la page Créer ou modifier une table à partir du chargement de fichier, veillez à sélectionner votre cluster en haut de la page. Choisissez ensuite le catalogue hive_metastore et son schéma par défaut pour créer une table nommée produits.

- Dans la page Explorateur de catalogue une fois la table produits créée, dans le menu du bouton Créer, sélectionnez Notebook pour créer un notebook.

-

Dans le notebook, vérifiez que le notebook est connecté à votre cluster, puis passez en revue le code automatiquement ajouté dans la première cellule et qui doit ressembler à ce qui suit :

%sql SELECT * FROM `hive_metastore`.`default`.`products`; - Utilisez l’option du menu ▸ Exécuter la cellule à gauche de la cellule pour l’exécuter, en démarrant et en attachant le cluster, si vous y êtes invité.

- Attendez que l’exécution de la tâche Spark par le code soit terminée. Le code récupère les données de la table créée en fonction du fichier téléchargé.

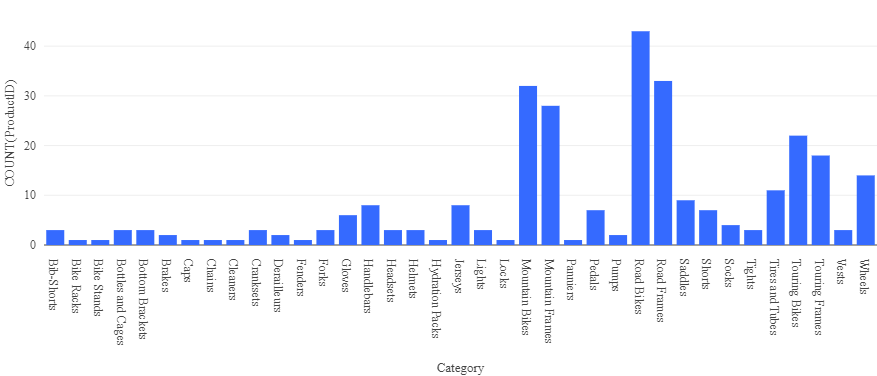

- Au-dessus du tableau des résultats, sélectionnez +, puis Visualisation pour afficher l’éditeur de visualisation et appliquer les options suivantes :

- Type de visualisation : barre

- Colonne X : catégorie

- Colonne Y : ajoutez une nouvelle colonne et sélectionnez ProductID. *Appliquez l’agrégation* **Count.

Enregistrez la visualisation et observez qu’elle s’affiche dans le notebook comme suit :

Analyser des données avec un dataframe

Bien que la plupart des analyses de données tolèrent l’utilisation de code SQL tel qu’il est utilisé dans l’exemple précédent, certains analystes des données et scientifiques des données peuvent utiliser des objets Spark natifs de type dataframe, dans des langages de programmation tels que PySpark (une version de Python optimisée avec Spark), pour utiliser des données de manière efficace.

-

Dans le notebook, sous la sortie de graphique de la cellule de code précédemment exécutée, utilisez l’icône + Code pour ajouter une nouvelle cellule.

Conseil : vous devrez peut-être déplacer la souris sous la cellule de sortie pour afficher l’icône + Code.

-

Entrez et exécutez le code suivant dans la nouvelle cellule :

df = spark.sql("SELECT * FROM products") df = df.filter("Category == 'Road Bikes'") display(df) -

Exécutez la nouvelle cellule qui retourne des produits dans la catégorie Road Bikes (Vélos de route).

Nettoyage

Dans le portail Azure Databricks, sur la page Calcul, sélectionnez votre cluster et sélectionnez ■ Arrêter pour l’arrêter.

Si vous avez terminé d’explorer Azure Databricks, vous pouvez supprimer les ressources que vous avez créées pour éviter les coûts Azure inutiles et libérer de la capacité dans votre abonnement.