Optimieren von Datenpipelines für eine bessere Leistung in Azure Databricks

Die Optimierung von Datenpipelines in Azure Databricks kann die Leistung und Effizienz erheblich steigern. Die Verwendung von Auto Loader für die inkrementelle Datenerfassung, gekoppelt mit der Speicherebene von Delta Lake, gewährleistet Zuverlässigkeit und ACID-Transaktionen. Durch die Implementierung von Salting kann Datenschiefe verhindert werden, während Z-Sortierungsclustering Dateilesevorgänge optimiert, indem verwandte Informationen zusammengeführt werden. Die Autooptimierungsfunktionen von Azure Databricks und der kostenbasierte Optimierer können die Leistung weiter verbessern, indem Einstellungen basierend auf den Workloadanforderungen angepasst werden.

Dieses Lab dauert ungefähr 30 Minuten.

Hinweis: Die Benutzeroberfläche von Azure Databricks wird kontinuierlich verbessert. Die Benutzeroberfläche kann sich seit der Erstellung der Anweisungen in dieser Übung geändert haben.

Bereitstellen eines Azure Databricks-Arbeitsbereichs

Tipp: Wenn Sie bereits über einen Azure Databricks-Arbeitsbereich verfügen, können Sie dieses Verfahren überspringen und Ihren vorhandenen Arbeitsbereich verwenden.

Diese Übung enthält ein Skript zum Bereitstellen eines neuen Azure Databricks-Arbeitsbereichs. Das Skript versucht, eine Azure Databricks-Arbeitsbereichsressource im Premium-Tarif in einer Region zu erstellen, in der Ihr Azure-Abonnement über ein ausreichendes Kontingent für die in dieser Übung erforderlichen Computekerne verfügt. Es wird davon ausgegangen, dass Ihr Benutzerkonto über ausreichende Berechtigungen im Abonnement verfügt, um eine Azure Databricks-Arbeitsbereichsressource zu erstellen. Wenn das Skript aufgrund unzureichender Kontingente oder Berechtigungen fehlschlägt, können Sie versuchen, einen Azure Databricks-Arbeitsbereich interaktiv im Azure-Portal zu erstellen.

- Melden Sie sich in einem Webbrowser am Azure-Portal unter

https://portal.azure.coman. -

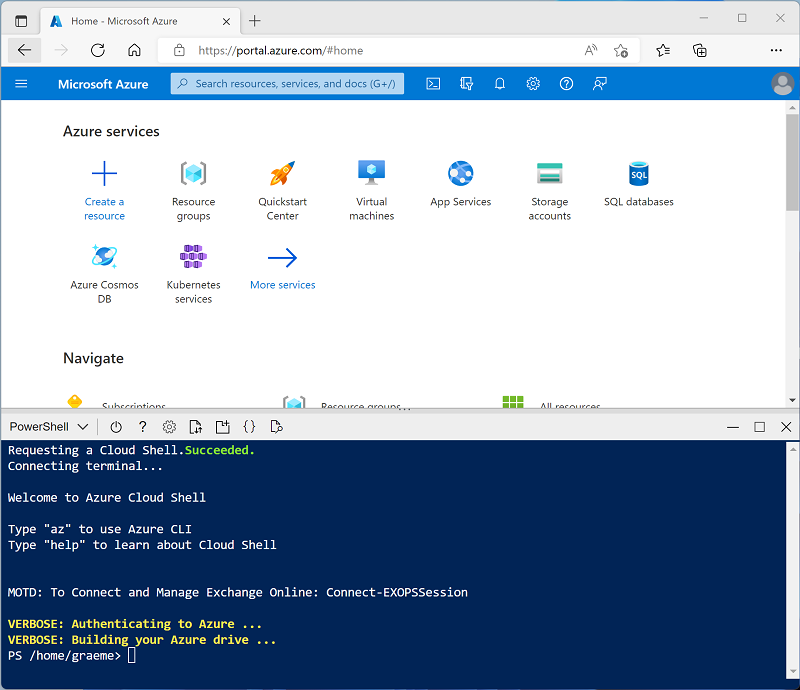

Verwenden Sie die Taste [>_] rechts neben der Suchleiste oben auf der Seite, um eine neue Cloud Shell im Azure-Portal zu erstellen, und wählen Sie eine PowerShell-Umgebung aus. Die Cloud Shell bietet eine Befehlszeilenschnittstelle in einem Bereich am unteren Rand des Azure-Portals, wie hier gezeigt:

Hinweis: Wenn Sie zuvor eine Cloud-Shell erstellt haben, die eine Bash-Umgebung verwendet, wechseln Sie zu PowerShell.

-

Beachten Sie, dass Sie die Größe der Cloud-Shell ändern können, indem Sie die Trennlinie oben im Bereich ziehen oder die Symbole —, ⤢ und X oben rechts im Bereich verwenden, um den Bereich zu minimieren, zu maximieren und zu schließen. Weitere Informationen zur Verwendung von Azure Cloud Shell finden Sie in der Azure Cloud Shell-Dokumentation.

-

Geben Sie im PowerShell-Bereich die folgenden Befehle ein, um dieses Repository zu klonen:

rm -r mslearn-databricks -f git clone https://github.com/MicrosoftLearning/mslearn-databricks -

Nachdem das Repository geklont wurde, geben Sie den folgenden Befehl ein, um das Skript setup.ps1 auszuführen, das einen Azure Databricks-Arbeitsbereich in einer verfügbaren Region bereitstellt:

./mslearn-databricks/setup.ps1 -

Wenn Sie dazu aufgefordert werden, wählen Sie aus, welches Abonnement Sie verwenden möchten (dies geschieht nur, wenn Sie Zugriff auf mehrere Azure-Abonnements haben).

- Warten Sie, bis das Skript abgeschlossen ist. Dies dauert in der Regel etwa 5 Minuten, in einigen Fällen kann es jedoch länger dauern. Während Sie warten, lesen Sie die Artikel Was ist ein Autoloader? und Optimieren des Datendatei-Layouts in der Azure Databricks-Dokumentation.

Erstellen eines Clusters

Azure Databricks ist eine verteilte Verarbeitungsplattform, die Apache Spark-Cluster verwendet, um Daten parallel auf mehreren Knoten zu verarbeiten. Jeder Cluster besteht aus einem Treiberknoten, um die Arbeit zu koordinieren, und Arbeitsknoten zum Ausführen von Verarbeitungsaufgaben. In dieser Übung erstellen Sie einen Einzelknotencluster , um die in der Lab-Umgebung verwendeten Computeressourcen zu minimieren (in denen Ressourcen möglicherweise eingeschränkt werden). In einer Produktionsumgebung erstellen Sie in der Regel einen Cluster mit mehreren Workerknoten.

Tipp: Wenn Sie bereits über einen Cluster mit einer Runtime 13.3 LTS oder einer höheren Runtimeversion in Ihrem Azure Databricks-Arbeitsbereich verfügen, können Sie ihn verwenden, um diese Übung abzuschließen und dieses Verfahren zu überspringen.

-

Navigieren Sie im Azure-Portal zur Ressourcengruppe msl-xxxxxxx, die vom Skript erstellt wurde (oder zur Ressourcengruppe, die Ihren vorhandenen Azure Databricks-Arbeitsbereich enthält).

-

Wählen Sie die Ressource Ihres Azure Databricks-Diensts aus (sie trägt den Namen databricks-xxxxxxx, wenn Sie das Setupskript zum Erstellen verwendet haben).

-

Verwenden Sie auf der Seite Übersicht für Ihren Arbeitsbereich die Schaltfläche Arbeitsbereich starten, um Ihren Azure Databricks-Arbeitsbereich auf einer neuen Browserregisterkarte zu öffnen. Melden Sie sich an, wenn Sie dazu aufgefordert werden.

Tipp: Während Sie das Databricks-Arbeitsbereichsportal verwenden, werden möglicherweise verschiedene Tipps und Benachrichtigungen angezeigt. Schließen Sie diese, und folgen Sie den Anweisungen, um die Aufgaben in dieser Übung auszuführen.

-

Wählen Sie in der linken Seitenleiste die Option (+) Neue Aufgabe und dann Cluster aus (ggf. im Untermenü Mehr suchen).

- Erstellen Sie auf der Seite Neuer Cluster einen neuen Cluster mit den folgenden Einstellungen:

- Clustername: Cluster des Benutzernamens (der Standardclustername)

- Richtlinie: Unrestricted

- Clustermodus: Einzelknoten

- Zugriffsmodus: Einzelner Benutzer (Ihr Benutzerkonto ist ausgewählt)

- Databricks-Runtimeversion: 13.3 LTS (Spark 3.4.1, Scala 2.12) oder höher

- Photonbeschleunigung verwenden: Ausgewählt

- Knotentyp: Standard_D4ds_v5

- Beenden nach 20 Minuten Inaktivität

-

Warten Sie, bis der Cluster erstellt wurde. Es kann ein oder zwei Minuten dauern.

Hinweis: Wenn Ihr Cluster nicht gestartet werden kann, verfügt Ihr Abonnement möglicherweise über ein unzureichendes Kontingent in der Region, in der Ihr Azure Databricks-Arbeitsbereich bereitgestellt wird. Details finden Sie unter Der Grenzwert für CPU-Kerne verhindert die Clustererstellung. In diesem Fall können Sie versuchen, Ihren Arbeitsbereich zu löschen und in einer anderen Region einen neuen zu erstellen. Sie können einen Bereich als Parameter für das Setupskript wie folgt angeben:

./mslearn-databricks/setup.ps1 eastus

Erstellen eines Notebook und Erfassen von Daten

-

Verwenden Sie in der Seitenleiste den Link (+) Neu, um ein Notebook zu erstellen und den Standardnamen des Notebooks (Unbenanntes Notebook [Datum]) in Optimierung der Datenerfassung zu ändern. Wählen Sie dann in der Dropdown-Liste Verbinden mit Ihren Cluster aus, falls er noch nicht ausgewählt ist. Wenn der Cluster nicht ausgeführt wird, kann es eine Minute dauern, bis er gestartet wird.

-

Geben Sie in der ersten Zelle des Notebooks den folgenden Code ein, der mit Shellbefehlen die Datendateien von GitHub in das von Ihrem Cluster verwendete Dateisystem herunterlädt.

%sh rm -r /dbfs/nyc_taxi_trips mkdir /dbfs/nyc_taxi_trips wget -O /dbfs/nyc_taxi_trips/yellow_tripdata_2021-01.parquet https://github.com/MicrosoftLearning/mslearn-databricks/raw/main/data/yellow_tripdata_2021-01.parquet -

Verwenden Sie unter der Ausgabe aus der ersten Zelle das Symbol “+Code “, um eine neue Zelle hinzuzufügen, und führen Sie den folgenden Code darin aus, um das Dataset in einen Datenrahmen zu laden:

# Load the dataset into a DataFrame df = spark.read.parquet("/nyc_taxi_trips/yellow_tripdata_2021-01.parquet") display(df) -

Verwenden Sie Menüoption ▸ Zelle Ausführen links neben der Zelle, um sie auszuführen. Warten Sie dann, bis der vom Code ausgeführte Spark-Auftrag, abgeschlossen ist.

Optimieren der Datenerfassung mit dem Autoloader:

Die Optimierung der Datenerfassung ist entscheidend für die effiziente Verarbeitung großer Datasets. Der Autoloader ist so konzipiert, dass neue Datendateien verarbeitet werden, sobald sie im Cloudspeicher ankommen und er unterstützt verschiedene Dateiformate und Cloudspeicherdienste.

Der Autoloader stellt eine strukturierte Streamingquelle namens cloudFiles bereit. Mithilfe eines Eingabeverzeichnispfads im Clouddateispeicher verarbeitet die cloudFiles-Quelle automatisch neue Dateien, sobald diese eingehen. Dabei können auch bereits vorhandene Dateien in diesem Verzeichnis verarbeitet werden.

-

Führen Sie den folgenden Code in einer neuen Zelle aus, um einen Datenstrom basierend auf dem Ordner, der die Beispieldaten enthält, zu erstellen:

df = (spark.readStream .format("cloudFiles") .option("cloudFiles.format", "parquet") .option("cloudFiles.schemaLocation", "/stream_data/nyc_taxi_trips/schema") .load("/nyc_taxi_trips/")) df.writeStream.format("delta") \ .option("checkpointLocation", "/stream_data/nyc_taxi_trips/checkpoints") \ .option("mergeSchema", "true") \ .start("/delta/nyc_taxi_trips") display(df) -

Führen Sie den folgenden Code in einer neuen Zelle aus, um dem Datenstrom eine neue Parquet-Datei hinzuzufügen:

%sh rm -r /dbfs/nyc_taxi_trips mkdir /dbfs/nyc_taxi_trips wget -O /dbfs/nyc_taxi_trips/yellow_tripdata_2021-02_edited.parquet https://github.com/MicrosoftLearning/mslearn-databricks/raw/main/data/yellow_tripdata_2021-02_edited.parquetDie neue Datei verfügt über eine neue Spalte, sodass der Datenstrom mit einem

UnknownFieldExceptionFehler beendet wird. Bevor Ihr Stream diesen Fehler auslöst, führt Autoloader einen Schemarückschluss für den letzten Mikrobatch von Daten durch und aktualisiert den Schemaspeicherort mit dem neuesten Schema, indem neue Spalten am Ende des Schemas zusammengeführt werden. Die Datentypen vorhandener Spalten bleiben unverändert. -

Führen Sie die Streaming-Code-Zelle erneut aus und überprüfen Sie, ob der Tabelle zwei neue Spalten (new_column und *_rescued_data) hinzugefügt wurden. Die Spalte **_rescued_data enthält alle Daten, die aufgrund von Typenkonflikt oder Groß-/Kleinschreibungsfehlern oder fehlenden Spalten im Schema nicht analysiert werden können.

-

Wählen Sie Unterbrechen aus, um das Datenstreaming zu beenden.

Die Streamingdaten werden in Delta-Tabellen geschrieben. Delta Lake bietet eine Reihe von Verbesserungen gegenüber herkömmlichen Parquet-Dateien, einschließlich ACID-Transaktionen, Schemaentwicklung, Zeitreise und vereint Streaming- und Batchdatenverarbeitung, was es zu einer leistungsstarken Lösung für die Verwaltung von Big Data-Workloads macht.

Optimierte Datentransformation

Datenschiefe ist eine erhebliche Herausforderung bei der verteilten Datenverarbeitung, insbesondere bei der Big Data-Verarbeitung mit Frameworks wie Apache Spark. Salting ist eine effektive Technik zum Optimieren der Datenschiefe, bei der den Schlüsseln vor der Partitionierung eine Zufallskomponente, das so genannte „Salt“, hinzugefügt wird. Dieser Prozess trägt dazu bei, Daten gleichmäßiger über Partitionen zu verteilen, was zu einer ausgewogeneren Workload und einer verbesserten Leistung führt.

-

Führen Sie in einer neuen Zelle den folgenden Code aus, um eine große schiefe Partition in kleinere Partitionen zu unterteilen, indem Sie eine Salz-Spalte mit zufälligen ganzzahligen Zahlen anfügen:

from pyspark.sql.functions import lit, rand # Convert streaming DataFrame back to batch DataFrame df = spark.read.parquet("/nyc_taxi_trips/*.parquet") # Add a salt column df_salted = df.withColumn("salt", (rand() * 100).cast("int")) # Repartition based on the salted column df_salted.repartition("salt").write.format("delta").mode("overwrite").save("/delta/nyc_taxi_trips_salted") display(df_salted)

Speicher optimieren

Delta Lake bietet eine Reihe von Optimierungsbefehlen, die die Leistung und Verwaltung von Datenspeichern erheblich verbessern können. Der optimize Befehl wurde entwickelt, um die Abfragegeschwindigkeit zu verbessern, indem Daten effizienter durch Techniken wie Komprimierung und Z-Sortierung organisiert werden.

Die Komprimierung konsolidiert kleinere Dateien in größere Dateien, was besonders für Leseabfragen von Vorteil sein kann. Bei der Z-Sortierung werden Datenpunkte so angeordnet, dass zusammengehörige Informationen nahe beieinander gespeichert werden, wodurch sich die Zeit, die für den Zugriff auf diese Daten bei Abfragen benötigt wird, verringert.

-

Führen Sie in einer neuen Zelle den folgenden Code aus, um die Komprimierung in der Delta-Tabelle auszuführen:

from delta.tables import DeltaTable delta_table = DeltaTable.forPath(spark, "/delta/nyc_taxi_trips") delta_table.optimize().executeCompaction() -

Führen Sie in einer neuen Zelle den folgenden Code aus, um Z-Sortierungsclustering auszuführen:

delta_table.optimize().executeZOrderBy("tpep_pickup_datetime")

Mit dieser Technik werden verwandte Informationen in derselben Gruppe von Dateien zusammengeführt, um die Abfrageleistung zu verbessern.

Bereinigen

Wählen Sie zunächst im Azure Databricks-Portal auf der Seite Compute Ihren Cluster und dann ■ Beenden aus, um ihn herunterzufahren.

Wenn Sie die Erkundung von Azure Databricks abgeschlossen haben, löschen Sie die erstellten Ressourcen, um unnötige Azure-Kosten zu vermeiden und Kapazität in Ihrem Abonnement freizugeben.