Azure AI サービスについて確認する

Azure AI サービスは、ユーザーがすぐに使用できる、事前構築済みでカスタマイズ可能な API とモデルを使用して、AI アプリケーションを作成するのに役立ちます。 この演習では、Azure portal でリソースを作成し、Azure AI サービスを試します。 この演習の目的は、Azure AI サービスのプロビジョニングと使用方法全般を理解することです。

Azure portal で Azure AI サービス リソースを作成します。

-

ブラウザー タブで Azure portal (https://portal.azure.com) を開き、自分の Azure サブスクリプションに関連付けられている Microsoft アカウントを使用してサインインします。

- [+リソースの作成] ボタンをクリックし、「Azure AI サービス」を検索してください。** [Azure AI サービスの作成] プランを選択してください。 Azure AI サービス リソースを作成するためのページに移動します。 これを以下の設定で構成します。

- [サブスクリプション]: お使いの Azure サブスクリプション。

- [リソース グループ]: 一意の名前のリソース グループを選択するか、作成します。

- [リージョン]: “地理的に最も近いリージョンを選びます。** 米国東部の場合は、[米国東部 2] を使用します”。

- [名前]: 一意の名前を入力します。

- 価格レベル: Standard S0。

- [このボックスをオンにすることにより、以下のすべてのご契約条件を読み、同意したものとみなされます]:オン。

-

[確認 + 作成]、[作成] の順に選択し、デプロイが完了するまで待ちます。

おめでとうございます。これで、Azure AI サービス リソースを作成、またはプロビジョニングしました。プロビジョニングしたリソースは、複数サービスのリソースです。

- デプロイが完了したら、[リソースに移動] を選択します。

キーとエンドポイントを確認する

Azure AI サービスをアプリケーションに組み込むには、開発者にはサービス キーとエンドポイントが必要です。 アプリケーション開発に使用されるキーとエンドポイントは、Azure portal 内で確認することができます。

- Azure portal で、リソースを選びます。 左側のメニューの [リソース管理] で [Keys and Endpoints] を見つけます。** ** [Keys and Endpoints] を選択して、お使いのリソースのエンドポイントとキーを表示します。

Azure AI サービスの仕組みを確認します

まず、Azure AI Foundry プロジェクトを作成します。

-

Web ブラウザーで Azure AI Foundry ポータル (

https://ai.azure.com) を開き、Azure 資格情報を使用してサインインします。 初めてサインインしたときに開かれたヒントまたはクイック スタート ペインを閉じます。 -

新しいブラウザー ウィンドウで、 Azure AI サービスの探索ページを開きます。

-

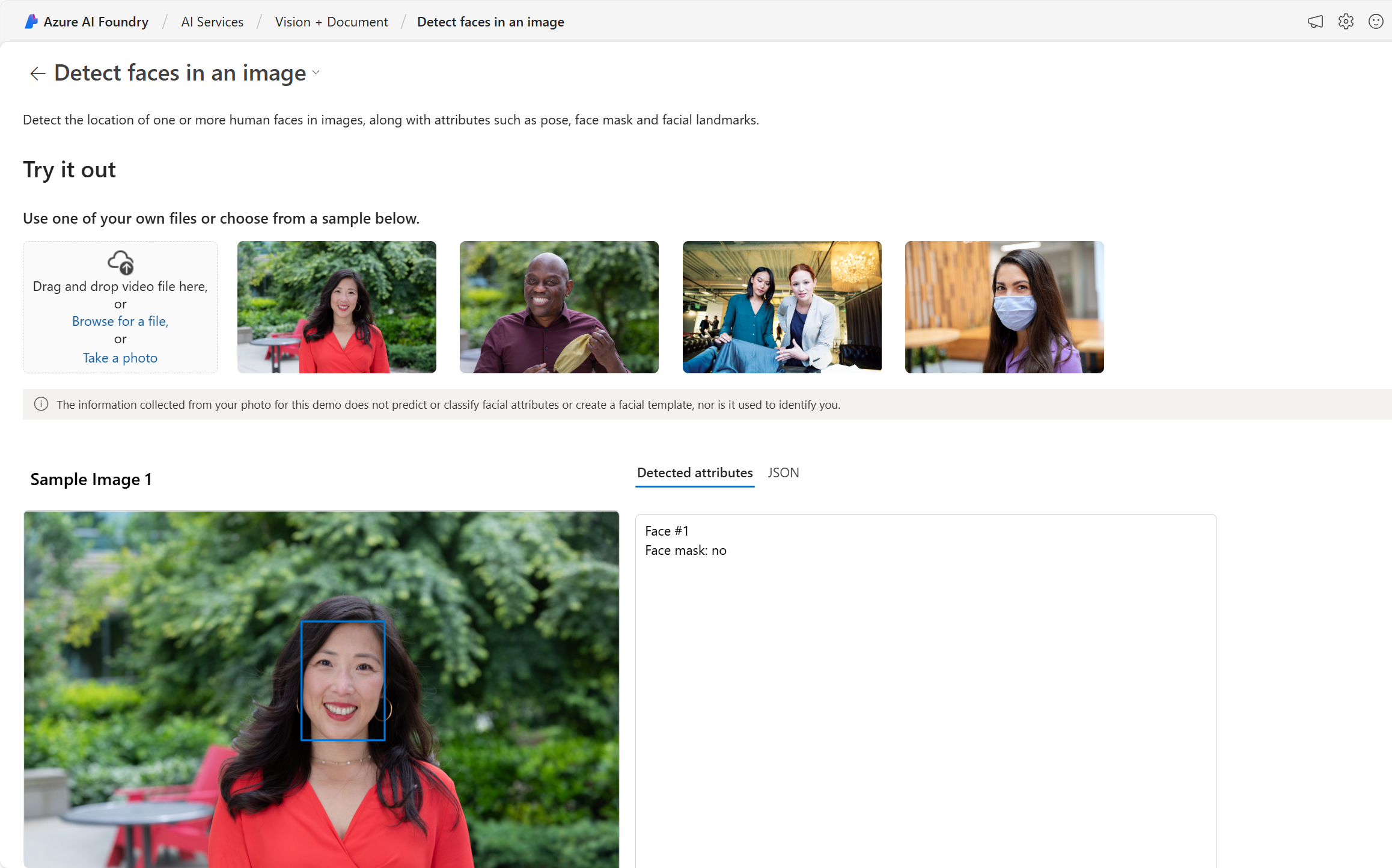

[AI サービス] ページで、[Vision + Document] タイルを選択して、Azure AI Vision とドキュメントの機能を試します。

![[AI サービス] ページで選択されている [Vision and Document] タイルのスクリーンショット。](/mslearn-ai-fundamentals.ja-jp/Instructions/Labs/media/vision-document-tile.png)

-

[すべての Vision 機能を表示] で、[顔] タブを選択します。

-

[画像の顔の検出] デモ タイルを選択します。

-

多くの Azure AI サービスの 1 つである顔認証サービスを試してみてください。 画像をクリックし、検出された属性を確認します。

-

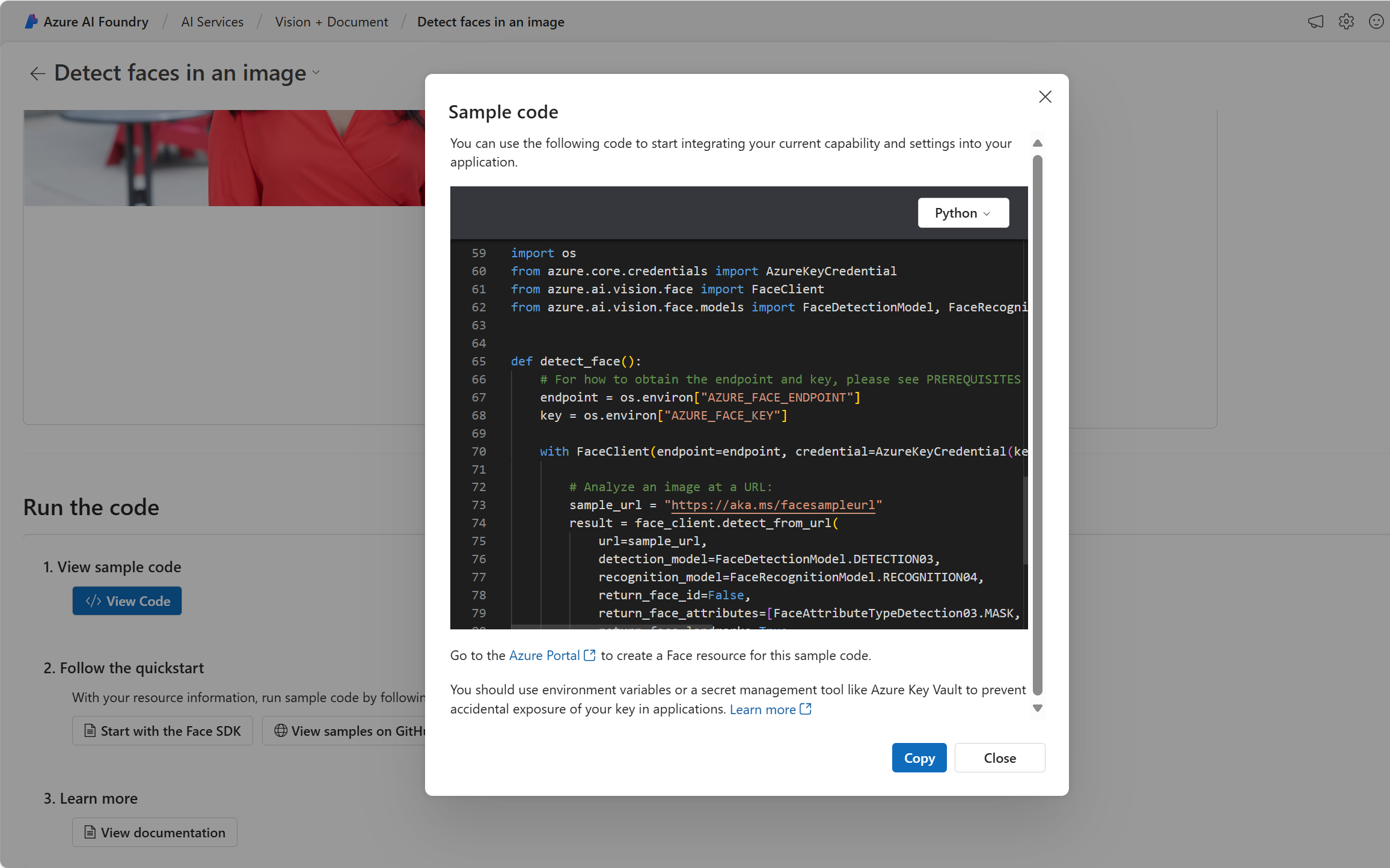

[コードの実行] セクションまで下にスクロールします。 [コードの表示] を選択します。 import as で始まるセクションまで下にスクロールします。 提供されているサンプル コードには、キーとエンドポイントを配置できるプレースホルダーが表示されます。

-

Azure AI サービスを使用するアプリケーションを構築する場合は、提供されたコードから開始できます。 プレースホルダーを自分のサービスのキーとエンドポイントに置き換えることで、アプリケーションはリクエストを送信し、Azure AI サービスを利用する応答を受信できるようになります。 顔認証サービスの場合、リクエストは顔認証サービスが画像を分析するためのものです。 応答は、検出された属性です。

注 このコースの演習を完了するためにプログラミングを知る必要はありません。 Azure AI Foundry ポータルを使用して、Azure AI サービスの仕組みを引き続き確認します。

クリーンアップ

完了したら、Azure portal から Azure AI サービス リソースを削除します。 リソースを削除することは、サブスクリプション内にリソースが存在する場合に生じるコストを削減する 1 つの方法です。 これを行うには、Azure AI サービス リソースの [概要] ページに移動します。 画面の上部で [削除] を選択します。