Erkunden von Azure Synapse Analytics

Azure Synapse Analytics bietet eine einzige, konsolidierte Datenanalyseplattform für End-to-End-Datenanalysen. In dieser Übung werden Sie verschiedene Möglichkeiten zum Erfassen und Untersuchen von Daten erkunden. Diese Übung ist eine allgemeine Übersicht über die verschiedenen Kernfunktionen von Azure Synapse Analytics. Weitere Übungen stehen zur Verfügung, um spezifische Funktionen ausführlicher zu erkunden.

Diese Übung dauert ca. 60 Minuten.

Vorbereitung

Sie benötigen ein Azure-Abonnement, in dem Sie Administratorzugriff besitzen.

Bereitstellen eines Azure Synapse Analytics-Arbeitsbereichs

Ein Azure Synapse Analytics- Arbeitsbereich bietet einen zentralen Punkt für die Verwaltung von Daten und Datenverarbeitungslaufzeiten. Sie können einen Arbeitsbereich mithilfe der interaktiven Benutzeroberfläche im Azure-Portal bereitstellen, oder Sie können einen Arbeitsbereich und Ressourcen darin mithilfe eines Skripts oder einer Vorlage bereitstellen. In den meisten Produktionsszenarien empfiehlt es sich, die Bereitstellung mit den Skripts und Vorlagen zu automatisieren, damit Sie die Ressourcenbereitstellung in einen wiederholbaren DevOps-Prozess (Development/Operations, Entwicklung/Betrieb) integrieren können.

In dieser Übung verwenden Sie eine Kombination aus einem PowerShell-Skript und einer ARM-Vorlage, um einen Azure Synapse Analytics-Arbeitsbereich bereitzustellen.

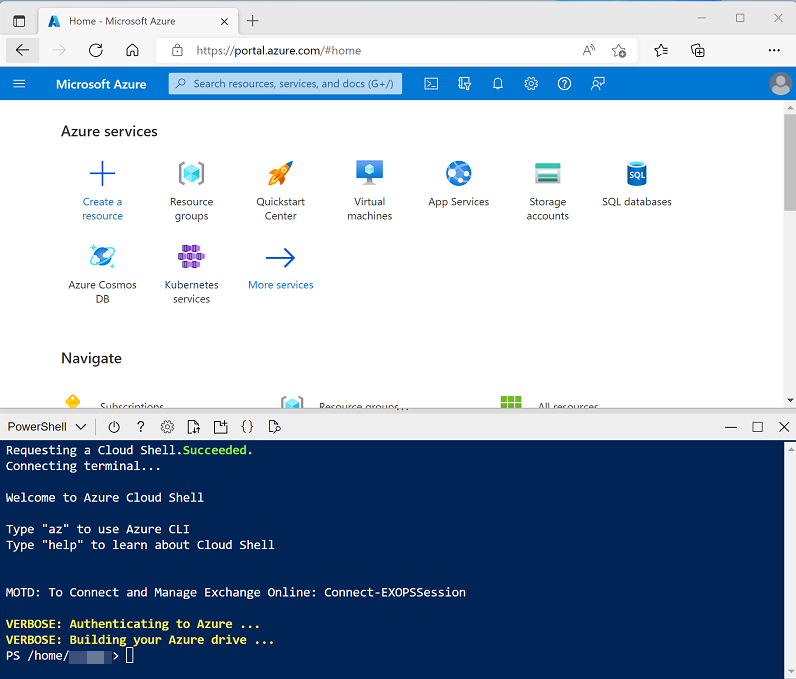

- Melden Sie sich in einem Browser beim Azure-Portal unter

https://portal.azure.coman. -

Verwenden Sie rechts neben der Suchleiste oben auf der Seite die Schaltfläche [>_], um eine neue Cloud Shell-Instanz im Azure-Portal zu erstellen. Wählen Sie eine PowerShell-Umgebung aus, und erstellen Sie Speicher, falls Sie dazu aufgefordert werden. Die Cloud Shell bietet eine Befehlszeilenschnittstelle in einem Bereich am unteren Rand des Azure-Portals, wie hier gezeigt:

Hinweis: Wenn Sie zuvor eine Cloudshell erstellt haben, die eine Bash-Umgebung verwendet, verwenden Sie das Dropdownmenü oben links im Bereich der Cloudshell, um sie in** Power Shell **zu ändern.

-

Beachten Sie, dass Sie die Größe der Cloud Shell durch Ziehen der Trennzeichenleiste oben im Bereich ändern können oder den Bereich mithilfe der Symbole —, ◻ und X oben rechts minimieren, maximieren und schließen können. Weitere Informationen zur Verwendung von Azure Cloud Shell finden Sie in der Azure Cloud Shell-Dokumentation.

-

Geben Sie im PowerShell-Bereich die folgenden Befehle ein, um dieses Repository zu klonen:

rm -r dp-203 -f git clone https://github.com/MicrosoftLearning/dp-203-azure-data-engineer dp-203 -

Nachdem das Repository geklont wurde, geben Sie die folgenden Befehle ein, um in den Ordner für diese Übung zu wechseln. Führen Sie das darin enthaltene Skript setup.ps1 aus:

cd dp-203/Allfiles/labs/01 ./setup.ps1 - Wenn Sie dazu aufgefordert werden, wählen Sie aus, welches Abonnement Sie verwenden möchten (dies geschieht nur, wenn Sie Zugriff auf mehrere Azure-Abonnements haben).

-

Wenn Sie dazu aufgefordert werden, geben Sie ein geeignetes Kennwort ein, das für Ihren Azure Synapse SQL-Pool festgelegt werden soll.

Hinweis: Merken Sie sich unbedingt dieses Kennwort! Darüber hinaus darf im Kennwort der Anmeldename nicht enthalten sein, und auch nicht ein Teil desselben.

- Warten Sie, bis das Skript abgeschlossen ist – dies dauert in der Regel etwa 20 Minuten, aber in einigen Fällen kann es länger dauern. Während Sie warten, lesen Sie den Artikel Was ist Azure Synapse Analytics? in der Dokumentation zu Azure Synapse Analytics.

Einstieg in Azure Synapse Studio

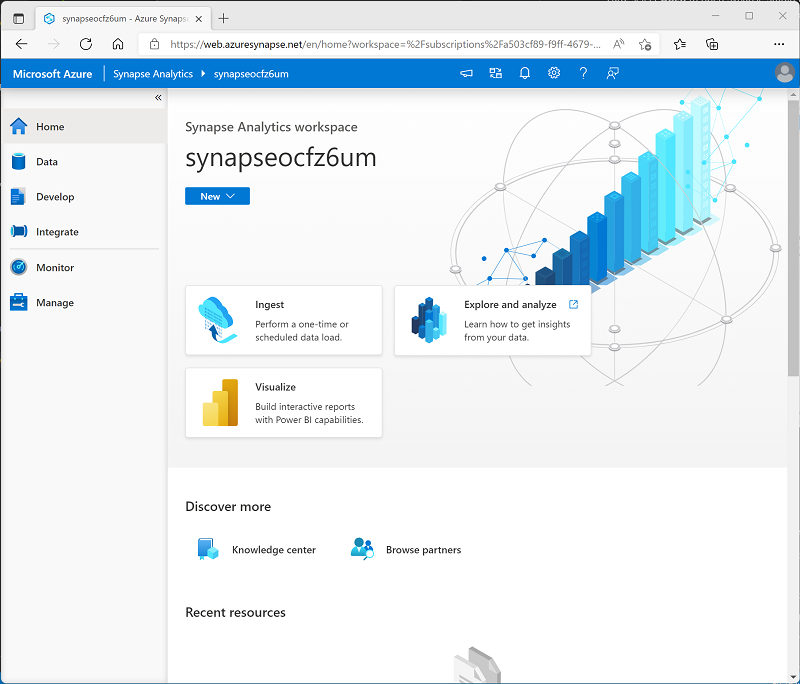

Synapse Studio ist eine webbasierte Oberfläche, in der Sie mit Ihrem Synapse Analytics-Arbeitsbereich arbeiten können.

- Wenn das Setupskript ausgeführt wurde, wechseln Sie im Azure-Portal zur von ihr erstellten Ressourcengruppe dp203-xxxxxxx und beachten Sie, dass diese Ressourcengruppe Ihren Synapse-Arbeitsbereich, ein Speicherkonto für Ihren Data Lake, einen Apache Spark-Pool und einen dedizierten SQL-Pool enthält.

- Wählen Sie Ihren Synapse-Arbeitsbereich aus, und klicken Sie auf der Seite Übersicht der Karte Synapse Studio öffnen auf die Option Öffnen, um Synapse Studio auf einer neuen Browserregisterkarte zu öffnen. Synapse Studio ist eine webbasierte Schnittstelle, die Sie zum Arbeiten mit Ihrem Synapse Analytics-Arbeitsbereich verwenden können.

-

Verwenden Sie auf der linken Seite von Synapse Studio das Symbol ››, um das Menü zu erweitern. Dadurch werden die verschiedenen Seiten in Synapse Studio angezeigt, die Sie zum Verwalten von Ressourcen und zum Ausführen von Datenanalyseaufgaben verwenden, wie im Folgenden gezeigt:

- Zeigen Sie die Seite Daten an, und beachten Sie, dass zwei Registerkarten mit Datenquellen vorhanden sind:

- Eine Registerkarte Arbeitsbereich mit Datenbanken, die im Arbeitsbereich definiert sind (einschließlich dedizierter SQL-Datenbanken und Daten-Explorer-Datenbanken)

- Eine Registerkarte Verknüpft mit Datenquellen, die mit dem Arbeitsbereich verknüpft sind, einschließlich Azure Data Lake-Speicher.

- Zeigen Sie die Seite Entwickeln an, die zurzeit leer ist. Hier können Sie Skripts und andere Ressourcen definieren, die zum Entwickeln von Datenverarbeitungslösungen verwendet werden.

- Zeigen Sie die Seite Integrieren an, die ebenfalls leer ist. Sie verwenden diese Seite, um Datenaufnahme- und Integrationsressourcen zu verwalten; z. B. Pipelines zum Übertragen und Transformieren von Daten zwischen Datenquellen.

- Zeigen Sie die Seite Monitor an. Hier können Sie Datenverarbeitungsaufträge beobachten, während sie ausgeführt werden und deren Verlauf anzeigen.

- Zeigen Sie die Seite Verwalten an. Hier verwalten Sie die Pools, Laufzeiten und anderen Ressourcen, die in Ihrem Azure Synapse-Arbeitsbereich verwendet werden. Zeigen Sie die einzelnen Registerkarten im Abschnitt Analysepools an und beachten Sie, dass Ihr Arbeitsbereich die folgenden Pools enthält:

- SQL-Pools:

- Integriert: Ein serverloser SQL-Pool, den Sie bei Bedarf verwenden können, um Daten in einem Data Lake mithilfe von SQL-Befehlen zu untersuchen oder zu verarbeiten.

- sqlxxxxxxx: Ein dedizierter SQL-Pool, der eine relationale Data Warehouse-Datenbank hostet.

- Apache Spark-Pools:

- sparkxxxxxxx: Sie können Daten in einem Data Lake mithilfe von Programmiersprachen wie Scala oder Python auf Bedarf untersuchen oder verarbeiten.

- SQL-Pools:

Erfassen von Daten mit einer Pipeline

Eine der wichtigsten Aufgaben, die Sie mit Azure Synapse Analytics ausführen können, ist das Definieren von Pipelines, die Daten aus einer Vielzahl von Quellen zur Analyse in Ihren Arbeitsbereich übertragen (und bei Bedarf transformieren).

Erstellen einer Pipeline mithilfe der Aufgabe „Daten kopieren“

- Wählen Sie in Synapse Studio auf der Startseite die Option Erfassen aus, um das Werkzeug Daten kopieren zu öffnen.

- Stellen Sie im Tool „Daten kopieren “im Schritt Eigenschaften sicher, dass die Optionen Integrierte Kopieraufgabe und Jetzt einmal ausführen ausgewählt sind, und klicken Sie auf Weiter >.

- Wählen Sie im Schritt Quelle im Teilschritt Dataset die folgenden Einstellungen aus:

- Quelltyp: Alle

- Verbindung: Erstellen Sie eine neue Verbindung, und wählen Sie im Fenster Verknüpfter Dienst auf der Registerkarte Generisches Protokoll die Option HTTP aus. Erstellen Sie dann unter Verwendung der folgenden Einstellungen eine Verbindung mit einer Datendatei:

- Name: Produkte

- Beschreibung: Produktliste über HTTP

- Verbindung über Integration Runtime herstellen: AutoResolveIntegrationRuntime

- Basis-URL:

https://raw.githubusercontent.com/MicrosoftLearning/dp-203-azure-data-engineer/master/Allfiles/labs/01/adventureworks/products.csv - Überprüfung des Serverzertifikats: Aktivieren

- Authentifizierungstyp: Anonym

- Stellen Sie nach dem Erstellen der Verbindung sicher, dass auf der Seite Quellendatenspeicher die folgenden Einstellungen ausgewählt sind, und klicken Sie dann auf Weiter >:

- Relative URL: Nicht ausfüllen

- Anforderungsmethode: GET

- Zusätzliche Kopfzeilen: Nicht ausfüllen

- Binärkopie: Nichtausgewählt

- Anforderungstimeout: Nicht ausfüllen

- Maximal zulässige Anzahl paralleler Verbindungen: Nicht ausfüllen

- Wählen Sie im Schritt Quelle im Teilschritt Konfiguration die Option Vorschaudaten aus, um eine Vorschau der von Ihrer Pipeline erfassten Produktdaten anzuzeigen, und schließen Sie dann die Vorschau.

- Stellen Sie nach dem Anzeigen der Datenvorschau sicher, dass auf der Seite Dateiformat Einstellungen die folgenden Einstellungen ausgewählt sind, und klicken Sie dann auf Weiter >:

- Dateiformat: DelimitedText

- Spaltentrennzeichen: Komma (,)

- Zeilen-Trennzeichen: Zeilenvorschub (\n)

- Erste Zeile ist Überschrift: Ausgewählt

- Komprimierungstyp: Keiner

- Wählen Sie im Schritt Ziel im Teilschritt Dataset die folgenden Einstellungen aus:

- Zieltyp: Azure Data Lake Storage Gen 2

- Verbindung: Wählen Sie die vorhandene Verbindung mit Ihrem Data Lake-Speicher aus (diese wurde bei der Erstellung des Arbeitsbereichs für Sie erstellt).

- Stellen Sie nach Auswahl der Verbindung sicher, dass im Schritt Ziel/Dataset die folgenden Einstellungen ausgewählt sind, und klicken Sie dann auf Weiter >:

- Ordnerpfad: Dateien/product_data

- Dateiname: products.csv

- Kopierverhalten: Keins

- Maximal zulässige Anzahl paralleler Verbindungen: Nicht ausfüllen

- Blockgröße (MB): Nicht ausfüllen

- Stellen Sie im Schritt Ziel im Teilschritt Konfiguration, auf der Seite Dateiformat Einstellungen sicher, dass die folgenden Eigenschaften ausgewählt sind. Klicken Sie anschließend auf Weiter >.

- Dateiformat: DelimitedText

- Spaltentrennzeichen: Komma (,)

- Zeilen-Trennzeichen: Zeilenvorschub (\n)

- Header zu Datei hinzufügen: Ausgewählt

- Komprimierungstyp: Keiner

- Maximale Zeilenanzahl pro Datei: Nicht ausfüllen

- Dateinamenpräfix: Nicht ausfüllen

- Konfigurieren Sie im Schritt Einstellungen die folgenden Einstellungen, und klicken Sie dann auf Weiter >.

- Aufgabenname: Kopieren von Produkten

- Aufgabenbeschreibung: Kopieren von Produktdaten

- Fehlertoleranz: Nicht ausfüllen

- Protokollierung aktivieren: Nicht ausgewählt

- Staging aktivieren: Nicht ausgewählt

- Lesen Sie im Schritt Überprüfen und fertig stellen im Teilschritt Überprüfen die Zusammenfassung, und klicken Sie dann auf Weiter >.

- Warten Sie im Schritt Bereitstellung, bis die Pipeline bereitgestellt wurde, und klicken Sie dann auf Fertig stellen.

- Wählen Sie in Synapse Studio die Seite Überwachen aus, und warten Sie, bis auf der Registerkarte Pipelineausführung die Pipeline Produkte kopieren mit dem Status Erfolgreich ausgeführt wurde. (Über die Schaltfläche ↻ Aktualisieren auf der Seite „Pipelineausführung“ können Sie den Status aktualisieren.)

- Zeigen Sie die Seite Integrieren an und stellen Sie sicher, dass sie jetzt eine Pipeline mit dem Namen Produkte kopieren enthält.

Anzeigen der erfassten Daten

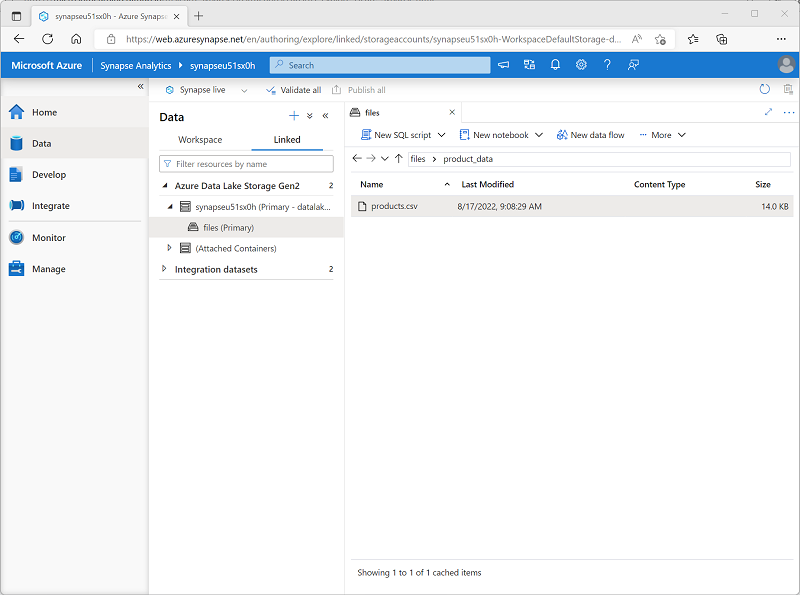

-

Wählen Sie auf der Seite Daten die Registerkarte Verknüpft aus und erweitern Sie die Containerhierarchie synapsexxxxxxx (Primär) Datalake, bis der Dateien Dateispeicher für Ihren Synapse-Arbeitsbereich angezeigt wird. Wählen Sie dann den Dateispeicher aus, um zu überprüfen, ob der Order product_data, der eine Datei namens products.csv enthält, an diesen Speicherort kopiert wurde, wie hier gezeigt:

-

Klicken Sie mit der rechten Maustaste auf die Datei products.csv und wählen Sie Vorschau aus, um die erfassten Daten anzuzeigen. Schließen Sie dann die Vorschau.

Verwenden eines serverlosen SQL-Pools zum Analysieren von Daten

Nachdem Sie nun einige Daten in Ihrem Arbeitsbereich erfasst haben, können Sie Synapse Analytics verwenden, um die Daten abzufragen und zu analysieren. Eine der gängigsten Methoden zum Abfragen von Daten ist die Verwendung von SQL. In Synapse Analytics können Sie zum Ausführen von SQL-Code gegen Daten in einem Data Lake einen serverlosen SQL-Pool verwenden.

- Klicken Sie in Synapse Studio mit der rechten Maustaste auf die products.csv-Datei im Dateispeicher Ihres Synapse-Arbeitsbereichs, zeigen Sie auf Neues SQL-Skript, und wählen Sie Die ersten 100 Zeilen auswählen aus.

-

Überprüfen Sie im geöffneten Bereich SQL-Skript 1 den generierten SQL Code, der in etwa wie der folgende lauten sollte:

-- This is auto-generated code SELECT TOP 100 * FROM OPENROWSET( BULK 'https://datalakexxxxxxx.dfs.core.windows.net/files/product_data/products.csv', FORMAT = 'CSV', PARSER_VERSION='2.0' ) AS [result]Dieser Code öffnet ein Rowset aus der importierten Textdatei und ruft die ersten 100 Datenzeilen ab.

- Vergewissern Sie sich, dass in der Liste Verbinden mit die Option Integriert ausgewählt ist. Dies entspricht dem integrierten SQL-Pool, der mit Ihrem Arbeitsbereich erstellt wurde.

-

Verwenden Sie die Symbolleistenschaltfläche ▷ Ausführen, um den SQL-Code auszuführen, und überprüfen Sie die Ergebnisse, die in etwa wie folgt aussehen sollten:

C1 C2 C3 C4 ProductID ProductName Kategorie ListPrice 771 Mountain-100 Silver, 38 Mountainbikes 3399.9900 772 Mountain-100 Silver, 42 Mountainbikes 3399.9900 … … … … -

Beachten Sie, dass die Ergebnisse aus vier Spalten mit den Namen C1, C2, C3 und C4 bestehen und dass die erste Zeile in den Ergebnissen die Namen der Datenfelder enthält. Um dieses Problem zu beheben, fügen Sie der OPENROWSET-Funktion wie hier gezeigt einen Parameter HEADER_ROW = TRUE hinzu (ersetzen Sie dabei datalakexxxxxxx durch den Namen Ihres Data Lake-Speicherkontos), und führen Sie dann die Abfrage erneut aus:

SELECT TOP 100 * FROM OPENROWSET( BULK 'https://datalakexxxxxxx.dfs.core.windows.net/files/product_data/products.csv', FORMAT = 'CSV', PARSER_VERSION='2.0', HEADER_ROW = TRUE ) AS [result]Die Ergebnisse sehen nun wie folgt aus:

ProductID ProductName Kategorie ListPrice 771 Mountain-100 Silver, 38 Mountainbikes 3399.9900 772 Mountain-100 Silver, 42 Mountainbikes 3399.9900 … … … … -

Ändern Sie die Abfrage wie folgt (ersetzen Sie datalakexxxxxxx durch den Namen Ihres Data Lake-Speicherkontos):

SELECT Category, COUNT(*) AS ProductCount FROM OPENROWSET( BULK 'https://datalakexxxxxxx.dfs.core.windows.net/files/product_data/products.csv', FORMAT = 'CSV', PARSER_VERSION='2.0', HEADER_ROW = TRUE ) AS [result] GROUP BY Category; -

Führen Sie die geänderte Abfrage aus, die ein Resultset zurückgeben sollte, das die folgende Produktanzahl in den jeweiligen Kategorien enthält:

Kategorie ProductCount Trägershorts 3 Fahrradträger 1 … … -

Ändern Sie im Bereich Eigenschaften den Namen für SQL-Skript 1 in Produkte nach Kategorie zählen. Klicken Sie dann auf der Symbolleiste auf Veröffentlichen, um das Skript zu speichern.

-

Schließen Sie den Skriptbereich Produkte nach Kategorie zählen.

-

Wählen Sie in Synapse Studio die Seite Entwickeln aus. Wie Sie sehen, ist hier Ihr veröffentlichtes SQL-Skript Produkte nach Kategorie zählen gespeichert.

-

Wählen Sie das SQL-Skript Produkte nach Kategorie zählen aus, um es erneut zu öffnen. Vergewissern Sie sicher, dass das Skript mit dem integrierten SQL-Pool verbunden ist, und führen Sie es aus, um die Produktanzahl abzurufen.

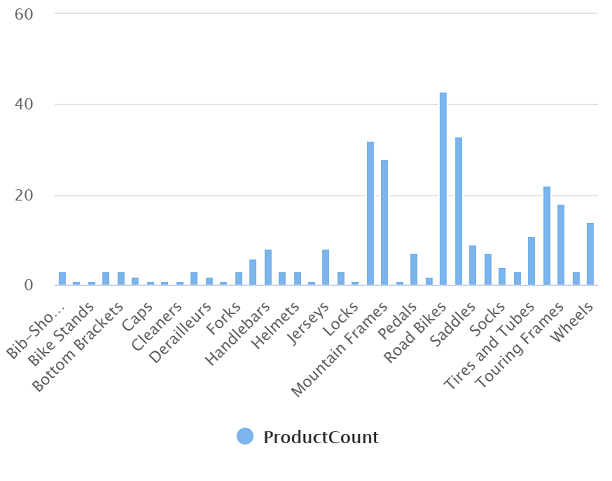

- Wählen Sie im Ergebnisbereich die Diagrammansicht aus, und nehmen Sie folgende Einstellungen für das Diagramm vor:

- Diagrammtyp: Spalte

- Kategoriespalte: Kategorie

- Legendenspalten (Reihen): ProductCount

- Legendenposition: Unten zentriert

- Legendenbeschriftung (Reihen): Nicht ausfüllen

- Mindestwert für Legende (Reihe): Nicht ausfüllen

- Höchstwert für Legende (Reihen): Nicht ausfüllen

- Kategoriebezeichnung: Nicht ausfüllen

Das resultierende Diagramm sollte in etwa wie folgt aussehen:

Verwenden eines Spark-Pools zum Analysieren von Daten

Während SQL eine gängige Sprache zum Abfragen strukturierter Datasets ist, finden viele Datenanalysten Sprachen wie Python nützlich, um Daten zu untersuchen und für die Analyse vorzubereiten. In Azure Synapse Analytics können Sie Python-Code (und anderen Code) in einem Spark-Pool ausführen, der eine auf Apache Spark basierende verteilte Datenverarbeitungsengine verwendet.

- in Synapse Studio, wenn die zuvor geöffnete Registerkarte Dateien, mit der Datei products.csv nicht mehr geöffnet ist, navigieren Sie auf der Seite Daten zum Ordner product_data. Klicken Sie dann mit der rechten Maustaste auf die Datei products.csv, zeigen Sie auf Neues Notebook, und wählen Sie In DataFrame laden aus.

- Wählen Sie im daraufhin angezeigten Bereich Notebook 1 in der Liste Anfügen an den Spark-Pool sparkxxxxxxx aus, den Sie zuvor erstellt haben, und stellen Sie sicher, dass die Sprache auf PySpark (Python) festgelegt ist.

-

Überprüfen Sie den Code in der ersten (und einzigen) Zelle des Notebooks, der wie folgt aussehen sollte:

%%pyspark df = spark.read.load('abfss://files@datalakexxxxxxx.dfs.core.windows.net/product_data/products.csv', format='csv' ## If header exists uncomment line below ##, header=True ) display(df.limit(10)) - Verwenden Sie das Symbol ▷ links neben der Codezelle, um sie auszuführen, und warten Sie auf die Ergebnisse. Wenn Sie eine Zelle zum ersten Mal in einem Notebook ausführen, wird der Spark-Pool gestartet. Es kann also etwa eine Minute dauern, bis Ergebnisse zurückgegeben werden.

-

Letztlich sollten die Ergebnisse unterhalb der Zelle angezeigt werden und in etwa wie folgt aussehen:

c0 c1 c2 c3 ProductID ProductName Kategorie ListPrice 771 Mountain-100 Silver, 38 Mountainbikes 3399.9900 772 Mountain-100 Silver, 42 Mountainbikes 3399.9900 … … … … -

Aufheben der Auskommentierung der Zeile ,header=True (da die products.csv-Datei die Spaltenüberschriften in der ersten Zeile enthält), sodass Ihr Code wie folgt aussieht:

%%pyspark df = spark.read.load('abfss://files@datalakexxxxxxx.dfs.core.windows.net/product_data/products.csv', format='csv' ## If header exists uncomment line below , header=True ) display(df.limit(10)) -

Führen Sie die Zelle erneut aus, und überprüfen Sie, ob die Ergebnisse wie folgt aussehen:

ProductID ProductName Kategorie ListPrice 771 Mountain-100 Silver, 38 Mountainbikes 3399.9900 772 Mountain-100 Silver, 42 Mountainbikes 3399.9900 … … … … Beachten Sie, dass das erneute Ausführen der Zelle weniger Zeit in Anspruch nimmt, da der Spark-Pool bereits gestartet wurde.

- Verwenden Sie unter den Ergebnissen das Symbol + Code, um dem Notebook eine neue Codezelle hinzuzufügen.

-

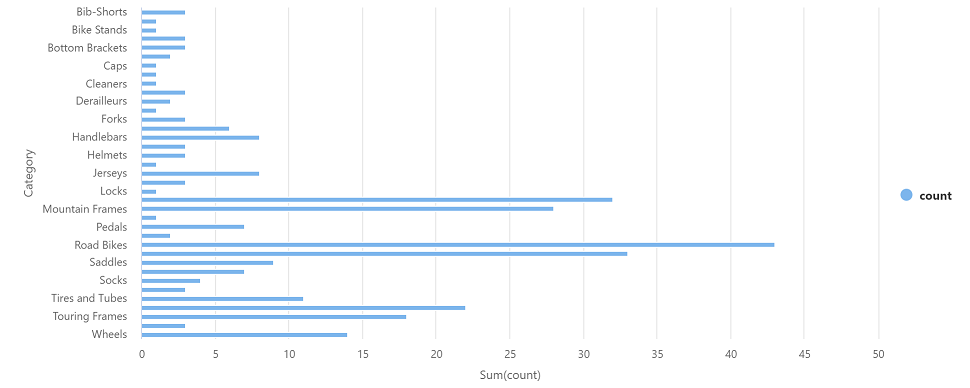

Fügen Sie in der neuen leeren Codezelle den folgenden Code hinzu:

df_counts = df.groupby(df.Category).count() display(df_counts) -

Führen Sie die neue Codezelle aus, indem Sie auf das zugehörige Symbol ▷ klicken, und überprüfen Sie die Ergebnisse, die in etwa wie folgt aussehen sollten:

Kategorie count Lenkköpfe 3 Räder 14 … … -

Wählen Sie in der Ergebnisausgabe für die Zelle die Diagrammansicht aus. Das resultierende Diagramm sollte in etwa wie folgt aussehen:

-

Wenn sie noch nicht sichtbar ist, zeigen Sie die Seite Eigenschaften an, indem Sie auf der rechten Seite der Symbolleiste die Schaltfläche Eigenschaften (ähnlich wie 🗏*) auswählen. Ändern Sie dann im Bereich Eigenschaften den Notizbuchnamen in Produkte erkunden und verwenden Sie die Schaltfläche Veröffentlichen auf der Symbolleiste, um ihn zu speichern.

- Schließen Sie den Notizbuchbereich, und beenden Sie die Spark-Sitzung, wenn Sie dazu aufgefordert werden. Zeigen Sie dann die Seite Entwickeln an, um zu überprüfen, ob das Notizbuch gespeichert wurde.

Verwenden eines dedizierten SQL-Pools zur Abfrage eines Data Warehouse

Sie haben bereits einige Techniken zum Untersuchen und Verarbeiten dateibasierter Daten in einem Data Lake kennen gelernt. In vielen Fällen verwendet eine Unternehmensanalyselösung einen Data Lake zum Speichern und Vorbereiten unstrukturierter Daten, die dann in ein relationales Data Warehouse geladen werden können, um Business Intelligence (BI)-Workloads zu unterstützen. In Azure Synapse Analytics können diese Data Warehouses in einem dedizierten SQL-Pool implementiert werden.

- Wählen Sie in Synapse Studio auf der Seite Verwalten im Abschnitt SQL-Pools die Zeile für den dedizierten SQL-Pool sqlxxxxxxx aus, und verwenden Sie dann das zugehörige Symbol ▷, um sie fortzusetzen.

- Warten Sie, bis der SQL-Pool gestartet wird. Dies kann einige Minuten dauern. Verwenden Sie die Schaltfläche ↻ Aktualisieren um den Status regelmäßig zu überprüfen. Der Status wird als Online angezeigt, wenn er bereit ist.

- Wenn der SQL-Pool gestartet wurde, wählen Sie die Seite Daten aus. Erweitern Sie auf der Registerkarte Arbeitsbereich SQL-Datenbanken und vergewissern Sie sich, dass sqlxxxxxxx aufgelistet ist (verwenden Sie das Symbol ↻ oben links auf der Seite, um die Ansicht bei Bedarf zu aktualisieren).

- Erweitern Sie die sqlxxxxxxx-Datenbank und deren Ordner Tabellen, gehen Sie dann im …-Menü für die Tabelle FactInternetSales zu Neues SQL-Skript und wählen Sie TOP 100 Zeilen auswählen aus.

- Überprüfen Sie die Ergebnisse der Abfrage, die die ersten 100 Verkaufstransaktionen in der Tabelle anzeigen. Diese Daten wurden vom Einrichtungsskript in die Datenbank geladen und dauerhaft in der Datenbank gespeichert, die dem dedizierten SQL-Pool zugeordnet ist.

-

Ersetzen Sie die SQL-Abfrage durch den folgenden Code:

SELECT d.CalendarYear, d.MonthNumberOfYear, d.EnglishMonthName, p.EnglishProductName AS Product, SUM(o.OrderQuantity) AS UnitsSold FROM dbo.FactInternetSales AS o JOIN dbo.DimDate AS d ON o.OrderDateKey = d.DateKey JOIN dbo.DimProduct AS p ON o.ProductKey = p.ProductKey GROUP BY d.CalendarYear, d.MonthNumberOfYear, d.EnglishMonthName, p.EnglishProductName ORDER BY d.MonthNumberOfYear - Verwenden Sie Schaltfläche ▷ Ausführen, um die geänderte Abfrage zur Anzeige der Anzahl der pro Jahr und Monat verkauften Produkte auszuführen.

-

Wenn sie noch nicht sichtbar ist, zeigen Sie die Seite Eigenschaften an, indem Sie auf der rechten Seite der Symbolleiste die Schaltfläche Eigenschaften (ähnlich wie 🗏*) auswählen. Ändern Sie dann im Bereich Eigenschaften den Abfragenamen in Aggregierte Produktverkäufe und verwenden Sie die Schaltfläche Veröffentlichen auf der Symbolleiste, um ihn zu speichern.

-

Schließen Sie den Abfragebereich, und zeigen Sie dann die Seite Entwickeln an, um zu überprüfen, ob das SQL-Skript gespeichert wurde.

- Wählen Sie auf der Seite Verwalten die dedizierte SQL-Poolzeile sqlxxxxxxx aus, und verwenden Sie dessen Symbol ❚ ❚, um es anzuhalten.

Löschen von Azure-Ressourcen

Nachdem Sie nun mit dem Erkunden von Azure Synapse Analytics fertig sind, löschen Sie die erstellten Ressourcen, um unnötige Azure-Kosten zu vermeiden.

- Schließen Sie die Registerkarte mit Synapse Studio, und kehren Sie zum Azure-Portal zurück.

- Wählen Sie auf der Startseite des Azure-Portals die Option Ressourcengruppen aus.

- Wählen Sie die Ressourcengruppe dp203-xxxxxxx für Ihren Synapse Analytics-Arbeitsbereich aus (nicht die verwaltete Ressourcengruppe), und vergewissern Sie sich, dass sie den Synapse-Arbeitsbereich, das Speicherkonto, den SQL-Pool und Spark-Pool für Ihren Arbeitsbereich enthält.

- Wählen Sie oben auf der Seite Übersicht für Ihre Ressourcengruppe die Option Ressourcengruppe löschen aus.

-

Geben Sie den Namen der Ressourcengruppe dp203-xxxxxxx ein, um zu bestätigen, dass Sie sie löschen möchten, und wählen Sie Löschen aus.

Nach einigen Minuten werden die Ressourcengruppe in Ihrem Azure Synapse-Arbeitsbereich und die damit verknüpfte Ressourcengruppe im verwalteten Arbeitsbereich gelöscht.